9、自动补全

9、自动补全

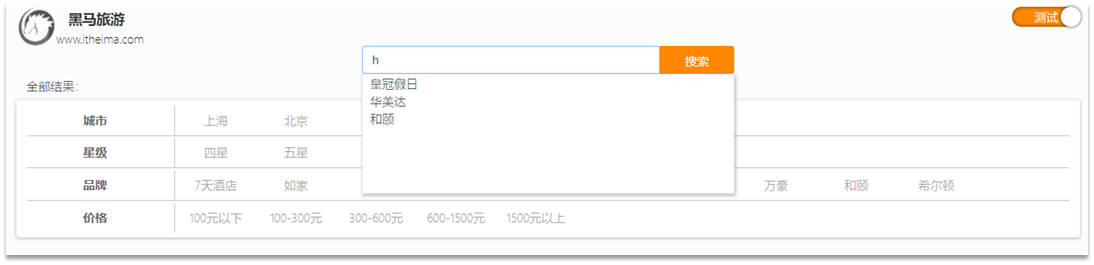

当用户在搜索框输入字符时,我们应该提示出与该字符有关的搜索项,如图:

这种根据用户输入的字母,提示完整词条的功能,就是自动补全了。

因为需要根据拼音字母来推断,因此要用到拼音分词功能。

1. 拼音分词器

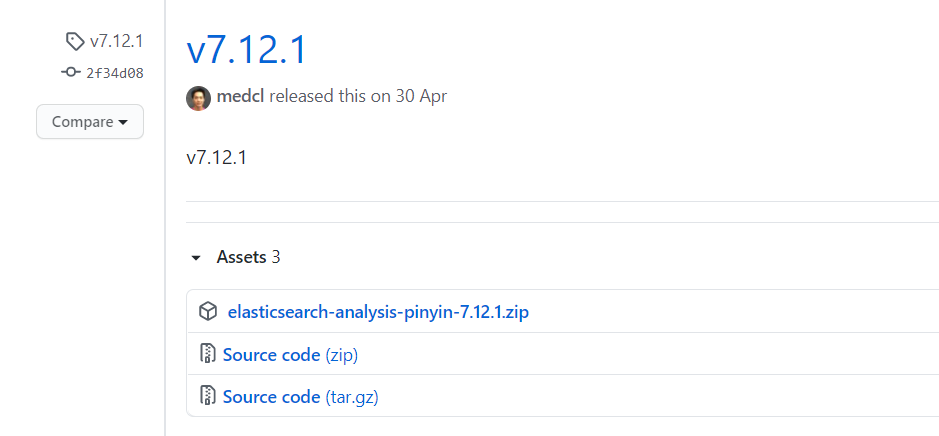

要实现根据字母做补全,就必须对文档按照拼音分词。在GitHub上恰好有elasticsearch的拼音分词插件。地址:https://github.com/medcl/elasticsearch-analysis-pinyin

安装方式与IK分词器一样,分三步:

①解压

②上传到虚拟机中,elasticsearch的plugin目录

③重启elasticsearch

④测试

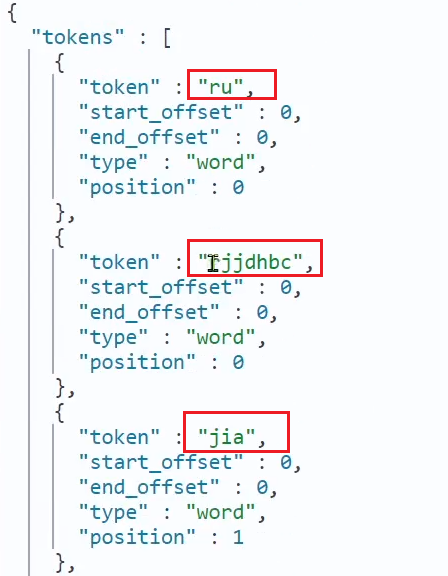

测试用法如下:

POST /_analyze

{

"text": "如家酒店还不错",

"analyzer": "pinyin"

}结果:

2. 自定义分词器

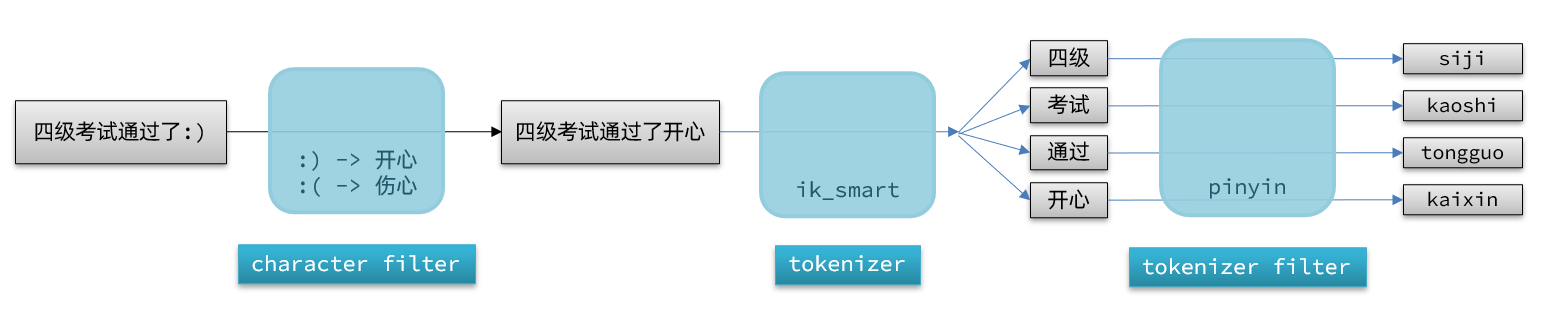

默认的拼音分词器会将每个汉字单独分为拼音,而我们希望的是每个词条形成一组拼音,需要对拼音分词器做个性化定制,形成自定义分词器。

elasticsearch中分词器(analyzer)的组成包含三部分:

- character filters:在tokenizer之前对文本进行处理。例如删除字符、替换字符

- tokenizer:将文本按照一定的规则切割成词条(term)。例如keyword,就是不分词;还有ik_smart

- tokenizer filter:将tokenizer输出的词条做进一步处理。例如大小写转换、同义词处理、拼音处理等

文档分词时会依次由这三部分来处理文档:

声明自定义分词器的语法如下:

PUT /test

{

"settings": {

"analysis": {

"analyzer": { // 自定义分词器

"my_analyzer": { // 分词器名称

"tokenizer": "ik_max_word",

"filter": "py"

}

},

"filter": { // 自定义tokenizer filter

"py": { // 过滤器名称

"type": "pinyin",

"keep_full_pinyin": false,

"keep_joined_full_pinyin": true,

"keep_original": true,

"limit_first_letter_length": 16,

"remove_duplicated_term": true,

"none_chinese_pinyin_tokenize": false

}

}

}

},

"mappings": {

"properties": {

"name": {

"type": "text",

"analyzer": "my_analyzer", # 保存文档内容时,使用自定义分词器-》写

"search_analyzer": "ik_smart" # 搜索时使用id_smart ---》读

}

}

}

}参数详细说明: keep_first_letter:这个参数会将词的第一个字母全部拼起来.例如:刘德华->ldh.默认为:true keep_separate_first_letter:这个会将第一个字母一个个分开.例如:刘德华->l,d,h.默认为:flase.如果开启,可能导致查询结果太过于模糊,准确率太低. limit_first_letter_length:设置最大keep_first_letter结果的长度,默认为:16 keep_full_pinyin:如果打开,它将保存词的全拼,并按字分开保存.例如:刘德华> [liu,de,hua],默认为:true keep_joined_full_pinyin:如果打开将保存词的全拼.例如:刘德华> [liudehua],默认为:false keep_none_chinese:将非中文字母或数字保留在结果中.默认为:true keep_none_chinese_together:保证非中文在一起.默认为: true, 例如: DJ音乐家 -> DJ,yin,yue,jia, 如果设置为:false, 例如: DJ音乐家 -> D,J,yin,yue,jia, 注意: keep_none_chinese应该先开启. keep_none_chinese_in_first_letter:将非中文字母保留在首字母中.例如: 刘德华AT2016->ldhat2016, 默认为:true keep_none_chinese_in_joined_full_pinyin:将非中文字母保留为完整拼音. 例如: 刘德华2016->liudehua2016, 默认为: false none_chinese_pinyin_tokenize:如果他们是拼音,切分非中文成单独的拼音项. 默认为:true,例如: liudehuaalibaba13zhuanghan -> liu,de,hua,a,li,ba,ba,13,zhuang,han, 注意: keep_none_chinese和keep_none_chinese_together需要先开启. keep_original:是否保持原词.默认为:false lowercase:小写非中文字母.默认为:true trim_whitespace:去掉空格.默认为:true remove_duplicated_term:保存索引时删除重复的词语.例如: de的>de, 默认为: false, 注意:开启可能会影响位置相关的查询. ignore_pinyin_offset:在6.0之后,严格限制偏移量,不允许使用重叠的标记.使用此参数时,忽略偏移量将允许使用重叠的标记.请注意,所有与位置相关的查询或突出显示都将变为错误,您应使用多个字段并为不同的字段指定不同的设置查询目的.如果需要偏移量,请将其设置为false。默认值:true

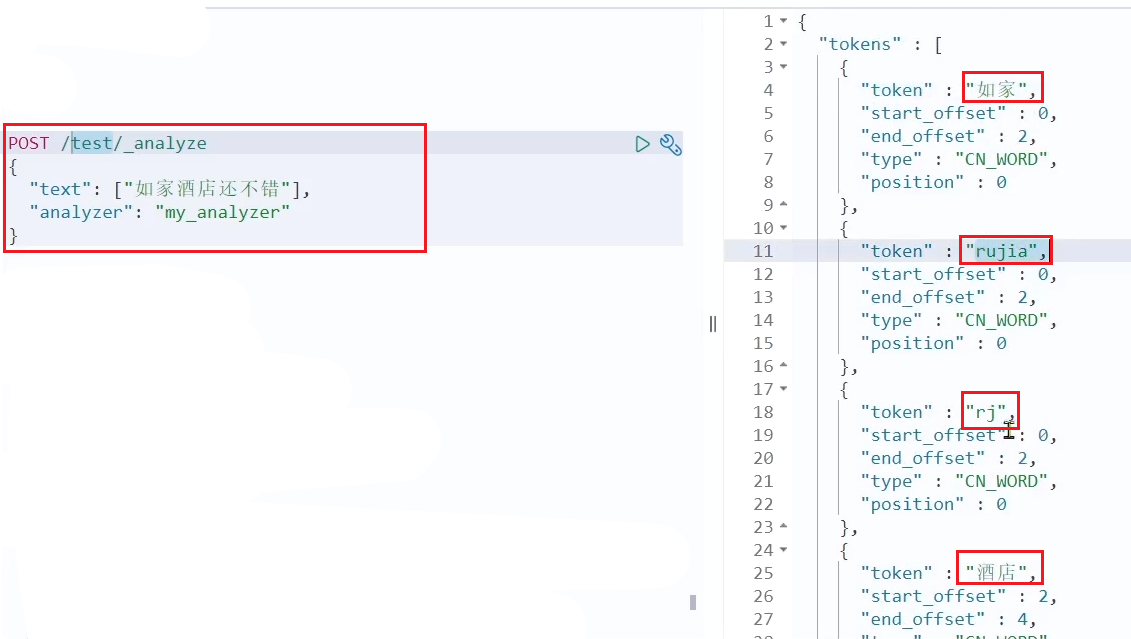

测试:

3. 自动补全查询

elasticsearch提供了Completion Suggester查询来实现自动补全功能。这个查询会匹配以用户输入内容开头的词条并返回。为了提高补全查询的效率,对于文档中字段的类型有一些约束:

参与补全查询的字段必须是completion类型。

字段的内容一般是用来补全的多个词条形成的数组。

比如,一个这样的索引库:

#创建索引库 存储关键字(completion)

PUT test2

{

"mappings": {

"properties": {

"title":{

"type": "completion"

}

}

}

}

# 查询索引库

GET /test2然后插入下面的数据:

POST test/_doc

{

"title": ["Sony", "WH-1000XM3"]

}

POST test/_doc

{

"title": ["SK-II", "PITERA"]

}

POST test/_doc

{

"title": ["Nintendo", "switch"]

}查询的DSL语句如下:

// 自动补全查询

GET /test/_search

{

"suggest": {

"title_suggest": {

"text": "s", // 关键字

"completion": {

"field": "title", // 补全查询的字段

"skip_duplicates": true, // 跳过重复的

"size": 10 // 获取前10条结果

}

}

}

}4. 准备工作

现在,我们的hotel索引库还没有设置拼音分词器,需要修改索引库中的配置。但是我们知道索引库是无法修改的,只能删除然后重新创建。

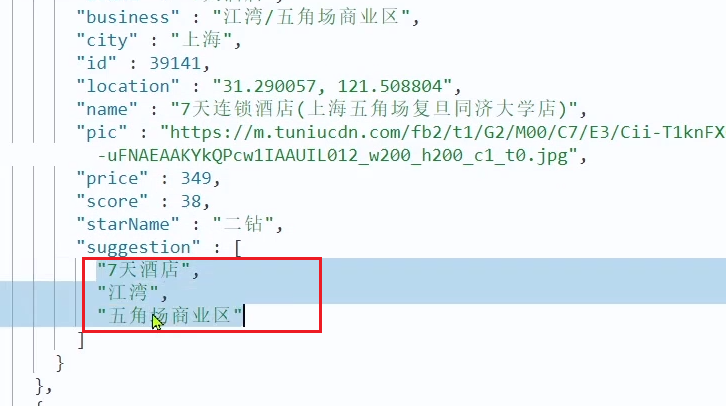

另外,我们需要添加一个字段,用来做自动补全,将brand、suggestion、city等都放进去,作为自动补全的提示。

修改检点映射结构

先删除先前的索引库

# 酒店数据索引库

PUT /hotel

{

"settings": {

"analysis": {

"analyzer": {

"text_anlyzer": {

"tokenizer": "ik_max_word",

"filter": "py"

},

"completion_analyzer": {

"tokenizer": "keyword",

"filter": "py"

}

},

"filter": {

"py": {

"type": "pinyin",

"keep_full_pinyin": false,

"keep_joined_full_pinyin": true,

"keep_original": true,

"limit_first_letter_length": 16,

"remove_duplicated_term": true,

"none_chinese_pinyin_tokenize": false

}

}

}

},

"mappings": {

"properties": {

"id":{

"type": "keyword"

},

"name":{

"type": "text",

"analyzer": "text_anlyzer",

"search_analyzer": "ik_smart",

"copy_to": "all"

},

"address":{

"type": "keyword",

"index": false

},

"price":{

"type": "integer"

},

"score":{

"type": "integer"

},

"brand":{

"type": "keyword",

"copy_to": "all"

},

"city":{

"type": "keyword"

},

"starName":{

"type": "keyword"

},

"business":{

"type": "keyword",

"copy_to": "all"

},

"location":{

"type": "geo_point"

},

"pic":{

"type": "keyword",

"index": false

},

"all":{

"type": "text",

"analyzer": "text_anlyzer",

"search_analyzer": "ik_smart"

},

"suggestion":{

"type": "completion",

"analyzer": "completion_analyzer"

}

}

}

}修改HotelDoc实体

package cn.itcast.hotel.pojo;

import lombok.Data;

import lombok.NoArgsConstructor;

import java.util.ArrayList;

import java.util.Arrays;

import java.util.Collections;

import java.util.List;

@Data

@NoArgsConstructor

public class HotelDoc {

private Long id;

private String name;

private String address;

private Integer price;

private Integer score;

private String brand;

private String city;

private String starName;

private String business;

private String location;

private String pic;

// 排序时的 距离值

private Object distance;

// 是否为广告

private Boolean isAD;

// 关键字维护

private List<String> suggestion;

public HotelDoc(Hotel hotel) {

this.id = hotel.getId();

this.name = hotel.getName();

this.address = hotel.getAddress();

this.price = hotel.getPrice();

this.score = hotel.getScore();

this.brand = hotel.getBrand();

this.city = hotel.getCity();

this.starName = hotel.getStarName();

this.business = hotel.getBusiness();

this.location = hotel.getLatitude() + ", " + hotel.getLongitude();

this.pic = hotel.getPic();

// 处理关键字

if (this.business.contains("/")){

// 身处多个商圈

String[] split = this.business.split("/");

// 创建集合

this.suggestion = new ArrayList<>();

this.suggestion.add(this.brand);

Collections.addAll(this.suggestion, split);

}else {

this.suggestion = Arrays.asList(this.brand, this.business);

}

}

}重新导入

/**

* 批量添加文档

*/

@Test

void testBulkAddDocument() throws IOException {

//1.创建请求对象 1:索引名称

BulkRequest request = new BulkRequest("hotel");

//2.数据库查询数据

List<Hotel> hotels = hotelMapper.selectList(null);

//3.添加文档数据

hotels.stream().forEach(hotel -> {

//1.将数据转换为json格式

HotelDoc hotelDoc = new HotelDoc(hotel);

String json = JSON.toJSONString(hotelDoc);

//2.添加IndexRequest文档数据

request.add(new IndexRequest("hotel")

.id(hotel.getId() + "")

.source(json, XContentType.JSON));

});

//4.发送请求 1:请求对象 2:请求配置

restHighLevelClient.bulk(request, RequestOptions.DEFAULT);

}

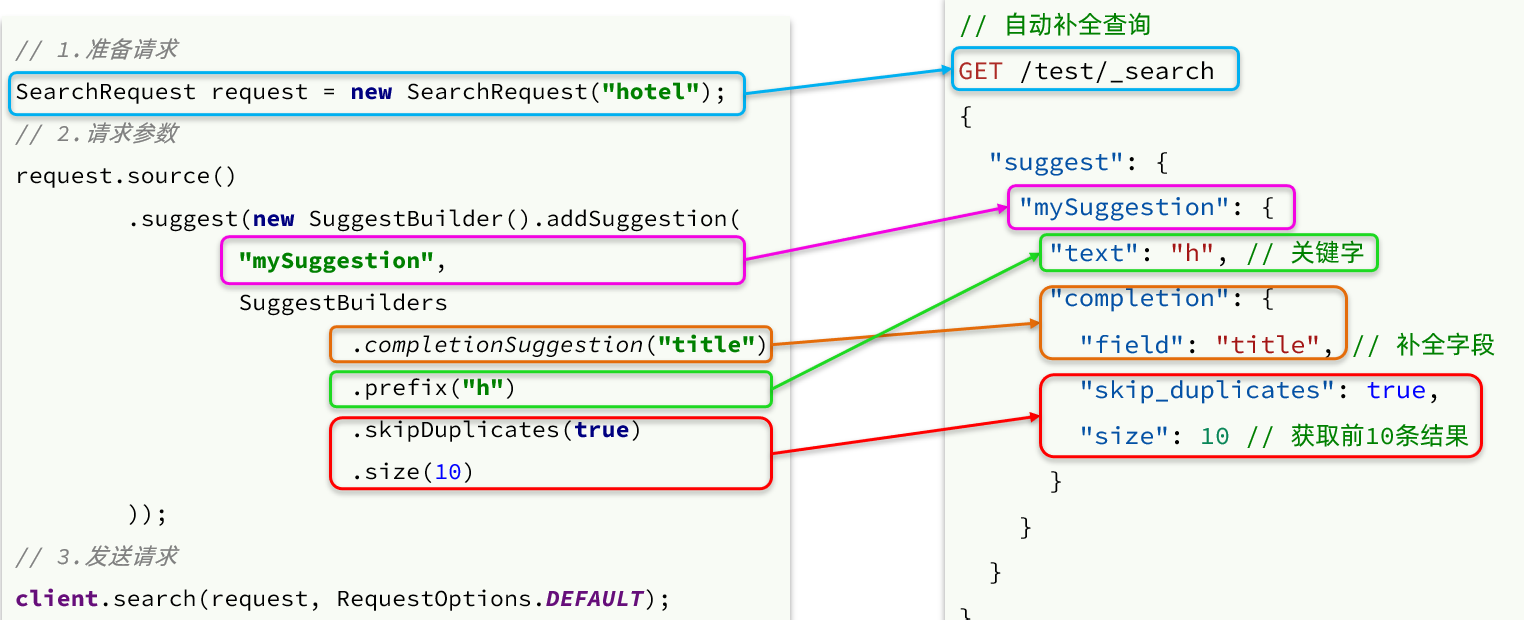

5. 自动补全查询的JavaAPI

之前我们学习了自动补全查询的DSL,而没有学习对应的JavaAPI,这里给出一个示例:

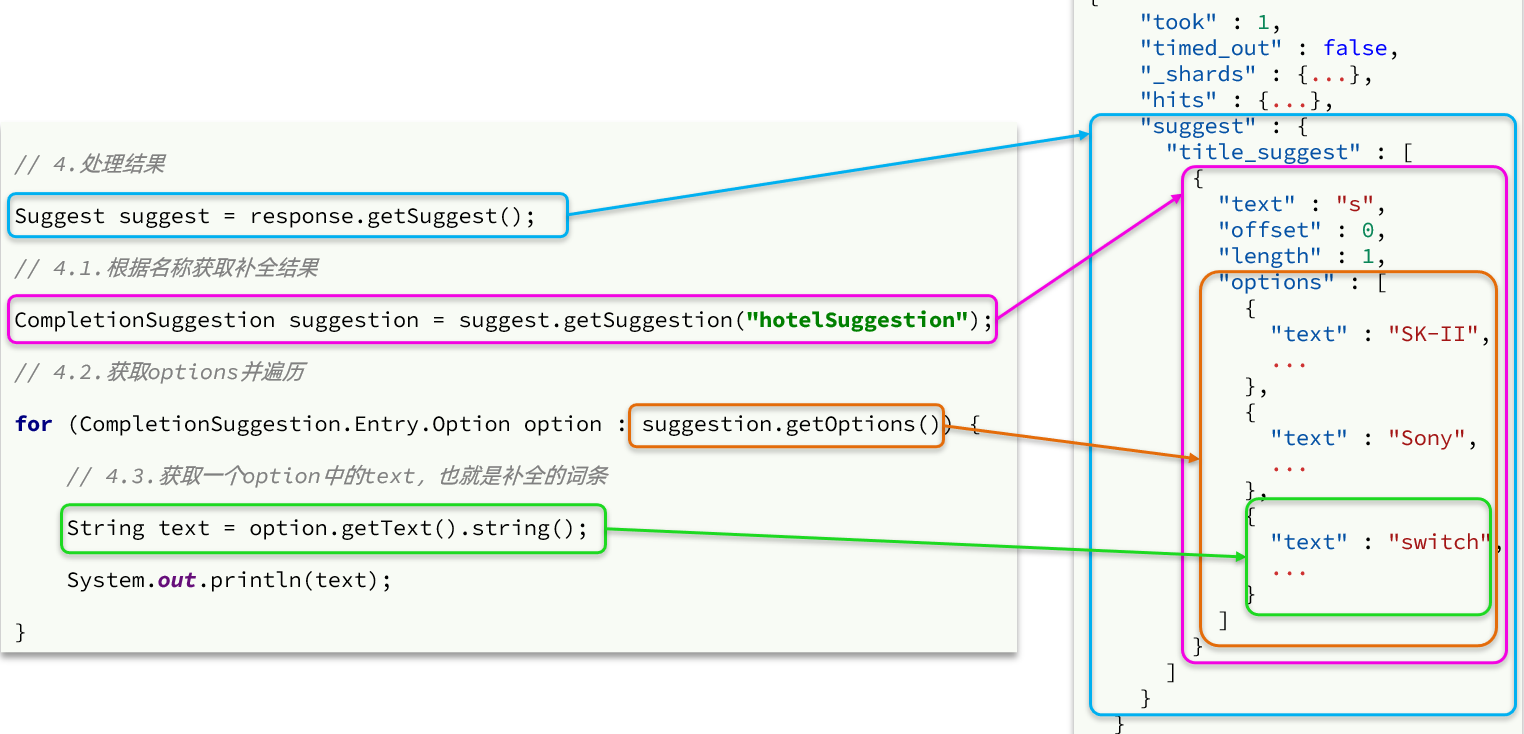

而自动补全的结果也比较特殊,解析的代码如下:

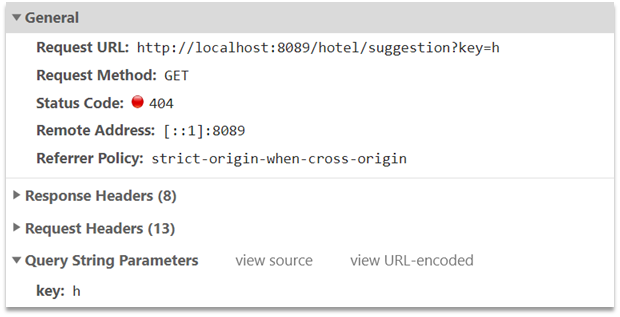

实现搜索框自动补全

返回值是补全词条的集合,类型为List<String>

/**

* 搜索框内容自动补全

*/

@GetMapping("/suggestion")

public List<String> suggestion(@RequestParam("key") String key) {

return hotelService.suggestion(key);

} /**

* 搜索建议

*

* @param key

* @return

*/

@Override

public List<String> suggestion(String key) {

//1. 创建请求对象

SearchRequest request = new SearchRequest("hotel");

//2. 构造DSL

request.source().suggest(

new SuggestBuilder().addSuggestion(

"suggestion", // 设置建议名称

SuggestBuilders.completionSuggestion("suggestion") // 设置建议字段

.skipDuplicates(true) //去重

.size(10) //设置数量

.prefix(key) //设置前缀

)

);

//3. 发送请求

SearchResponse response =null;

try {

response = client.search(request, RequestOptions.DEFAULT);

} catch (IOException e) {

throw new RuntimeException("搜索建议业务时发送请求异常");

}

//4. 解析响应

ArrayList<String> sugList = new ArrayList<>();

Suggest suggest = response.getSuggest();

CompletionSuggestion hotelSuggestion = suggest.getSuggestion("suggestion");

if (hotelSuggestion.getOptions() == null || CollectionUtils.isEmpty(hotelSuggestion.getOptions())) {

return sugList;

}

List<CompletionSuggestion.Entry.Option> options = hotelSuggestion.getOptions();

options.stream().forEach(option -> {

String sug = option.getText().string();

sugList.add(sug);

});

return sugList;

}